Construire des solutions d’IA avec des algorithmes d’IA éthiques et transparents

Garantir des technologies responsables et fiables pour l’avenir

Construire des solutions d'IA avec des algorithmes d'IA éthiques et transparents

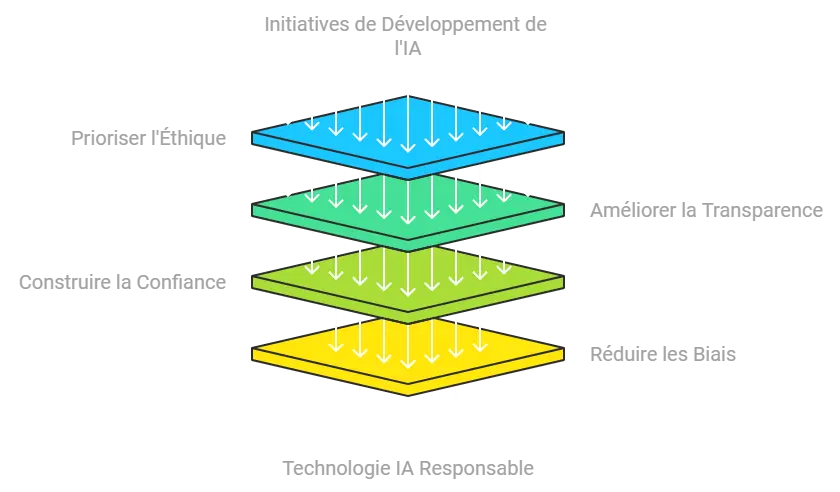

Alors que l’intelligence artificielle (IA) continue d’envahir presque tous les secteurs, l’importance de l’éthique et de la transparence dans le développement de l’IA n’a jamais été aussi cruciale. L’élaboration de solutions d’IA qui donnent la priorité aux considérations éthiques et à la transparence peut favoriser la confiance, réduire les préjugés et créer une technologie plus responsable. Dans cet article, nous aborderons les principes clés, les défis et les étapes de la création de systèmes d’IA qui respectent les normes éthiques et maintiennent la transparence.

Table des matières

ToggleIntroduction à l'IA éthique et transparente

Les algorithmes d’IA prennent des décisions qui ont un impact sur la vie des gens, qu’il s’agisse de déterminer des scores de crédit ou d’embaucher des candidats, et les considérations éthiques de ces systèmes sont essentielles. L’IA éthique donne la priorité à l’équité, à la responsabilité et à la transparence, en veillant à ce que la technologie de l’IA respecte les droits individuels et promeuve l’égalité. L’IA transparente, quant à elle, permet aux parties prenantes de comprendre le fonctionnement de ces systèmes et de s’y fier. La recherche combinée de l’éthique et de la transparence favorise des solutions d’IA plus justes, plus sûres et plus conformes aux valeurs sociétales.

Principes clés de l’IA éthique

1. Équité et atténuation des préjugés

Les biais dans l'IA peuvent conduire à des résultats discriminatoires, en particulier lorsque les algorithmes sont formés sur des ensembles de données qui reflètent les préjugés de la société. L'équité garantit que les systèmes d'IA ne favorisent pas injustement un groupe par rapport à un autre, ce qui nécessite un traitement minutieux des données d'entraînement afin d'éliminer ou de réduire les biais. Des techniques d'atténuation des biais telles que la repondération, l'équilibrage des données et l'ajustement des algorithmes sont utilisées pour relever ces défis.

2. Obligation de rendre compte et responsabilité

Les développeurs d'IA et les organisations doivent être responsables des décisions prises par leurs algorithmes. L'obligation de rendre compte dans le domaine de l'IA implique la mise en place d'une chaîne de responsabilité claire afin que les actions puissent être retracées jusqu'aux personnes responsables du développement, de la mise en œuvre et du déploiement. Cela peut aider les organisations à gérer leur responsabilité et à s'assurer qu'elles sont prêtes à faire face aux dommages potentiels causés par leurs systèmes d'IA.

3. Vie privée et protection des données

Étant donné que de nombreux algorithmes d'IA s'appuient sur des données personnelles pour fonctionner, la confidentialité et la protection des données sont primordiales. Le développement éthique de l'IA inclut le respect de la vie privée des utilisateurs en adhérant à des réglementations telles que le Règlement général sur la protection des données (RGPD) et le California Consumer Privacy Act (CCPA), qui décrivent comment les données peuvent être collectées, stockées et traitées.

4. Transparence et explicabilité

La transparence permet aux parties prenantes de comprendre le fonctionnement des systèmes d'IA, ce qui est essentiel pour instaurer la confiance. L'explicabilité fait référence à la capacité d'interpréter et de comprendre les décisions prises par les modèles d'IA. Avec l'IA explicable, les développeurs peuvent présenter un raisonnement clair derrière les résultats de leurs algorithmes, ce qui facilite la détection de biais ou d'erreurs potentiels.

Défis liés à la mise en place d’une IA éthique et transparente

Biais et représentation des données

L'un des principaux défis du développement éthique de l'IA est la distorsion des données, qui se produit lorsque les ensembles de données d'entraînement ne représentent pas fidèlement la diversité des données du monde réel. Les données biaisées peuvent fausser les résultats de l'IA et conduire à des décisions injustes qui ont un impact disproportionné sur certains groupes.

Absence de réglementation claire

L'IA est un domaine qui évolue rapidement et les cadres réglementaires ont souvent du mal à suivre le rythme. De nombreux pays sont en train de rédiger des réglementations sur l'IA, mais en attendant, les organisations sont confrontées à l'ambiguïté des normes éthiques et des obligations légales. En raison de cette absence de réglementation, les développeurs peuvent avoir du mal à savoir comment se conformer aux attentes éthiques.

Complexité de la prise de décision en matière d'IA

De nombreux algorithmes d'IA, en particulier les modèles d'apprentissage profond, fonctionnent comme des "boîtes noires", ce qui signifie que leurs processus internes sont complexes et difficiles à interpréter. Les systèmes d'IA de type "boîte noire" peuvent nuire à la transparence et à l'explicabilité, car il est alors difficile de déterminer le raisonnement qui sous-tend certains résultats ou certaines décisions.

Étapes de la création d'algorithmes d'IA éthiques et transparents

Étape 1 : Établir des lignes directrices en matière d'éthique

Les organisations devraient commencer par définir un ensemble de lignes directrices éthiques pour le développement de l'IA. Ces lignes directrices servent de cadre pour garantir que les algorithmes d'IA respectent les principes d'équité, de transparence et de responsabilité. Une base éthique solide encourage également les développeurs à identifier les dilemmes éthiques potentiels et à les résoudre avant qu'ils ne deviennent des problèmes.

Étape 2 : Intégrer la détection et l'atténuation des biais

La détection et l'atténuation des préjugés sont essentielles à la mise en place d'une IA équitable et éthique. Les outils de détection des biais, tels que AI Fairness 360 d'IBM et What-If Tool de Google, aident les développeurs à analyser les données et à modéliser les comportements pour repérer les traitements injustes. Les techniques d'atténuation peuvent inclure :

- Rééquilibrage des données : Ajustement de l'ensemble de données de formation pour inclure des échantillons divers.

- Ajustements algorithmiques : Modifier les algorithmes pour qu'ils soient moins sensibles aux données biaisées.

- Suivi régulier : Évaluer en permanence les résultats du modèle pour détecter les distorsions au fil du temps.

Étape 3 : Garantir la confidentialité et la sécurité des données

La confidentialité des données est une pierre angulaire de l'IA éthique. Les développeurs doivent suivre les meilleures pratiques en matière de cryptage des données, d'anonymisation et de contrôle d'accès pour protéger les données des utilisateurs. L'intégration des principes de protection de la vie privée dès la conception, où les considérations relatives à la protection de la vie privée sont intégrées à chaque étape du développement, aide à maintenir la conformité et la confiance des utilisateurs.

Étape 4 : Favoriser la transparence et l'explicabilité

Les algorithmes d'IA doivent être interprétables afin que les parties prenantes puissent comprendre comment les décisions sont prises. Les techniques d'explicitation peuvent inclure:

- LIME (Local Interpretable Model-Agnostic Explanations) : Un outil qui aide à interpréter les prédictions des modèles.

- SHAP (Shapley Additive Explanations) : Permet d'expliquer les contributions des caractéristiques aux prédictions.

Ces outils permettent aux développeurs de fournir des informations sur le fonctionnement des modèles, ce qui permet aux parties prenantes de se fier plus facilement aux décisions.

Étape 5 : Procéder à des audits et à des évaluations réguliers

Des audits réguliers des algorithmes d'IA aident les organisations à identifier et à rectifier tout biais ou problème éthique survenant au cours du déploiement. Les audits peuvent comprendre l'analyse des résultats à la recherche de modèles discriminatoires, l'évaluation de la qualité des données et la vérification du respect des normes éthiques.

Outils pour construire une IA éthique et transparente

| Outil | Fonction | Objectif |

|---|---|---|

| IBM AI Fairness 360 | Détection et atténuation des biais | IBM AI Fairness 360 Détection et atténuation des biais Identifie et réduit les biais dans les modèles |

| Google’s What-If Tool | Inspection du modèle et analyse des biais | Analyse le comportement du modèle pour en vérifier l'équité |

| LIME | Explicabilité du modèle | Fournit des informations sur les prévisions du modèle |

| SHAP | Analyse de la contribution des caractéristiques | Explique comment les caractéristiques influencent les résultats |

| Differential Privacy Libraries | Protection de la vie privée | Garantir la confidentialité des données pendant l'apprentissage du modèle |

Études de cas : Les entreprises à la pointe de l'IA éthique I

Microsoft

Microsoft a mis en place un programme complet d'éthique de l'IA, qui comprend un comité d'éthique de l'IA chargé d'examiner les risques potentiels. Grâce à des initiatives telles que la Fairness Checklist, Microsoft intègre des considérations éthiques dans ses solutions d'IA, promouvant ainsi la transparence dans leurs processus de prise de décision.

IBM

IBM est à la pointe de l'industrie avec son outil open-source, AI Fairness 360, qui aide les développeurs à détecter et à atténuer les préjugés. La politique de transparence d'IBM exige que tous les modèles d'IA divulguent des informations sur leurs sources de données, leurs méthodologies et leurs limites, établissant ainsi une norme élevée pour le développement éthique de l'IA.

Google utilise des lignes directrices en matière de transparence et de responsabilité dans le développement de l'IA, en intégrant des outils tels que What-If Tool et Explainable AI pour évaluer l'équité de ses modèles. L'accent mis par Google sur l'explicabilité renforce la confiance, en permettant aux parties prenantes de comprendre les processus de prise de décision en matière d'IA.

Conclusion

L'élaboration de solutions d'IA éthiques et transparentes est essentielle pour favoriser la confiance, réduire les préjugés et garantir l'équité de la technologie. En donnant la priorité à l'équité, à la responsabilité, à la confidentialité des données et à la transparence, les organisations peuvent créer des systèmes d'IA responsables qui respectent les valeurs sociétales et promeuvent l'égalité. À mesure que l'IA continue d'évoluer, les pratiques éthiques joueront un rôle de plus en plus important, d'où la nécessité pour les développeurs de comprendre et de mettre en œuvre ces principes à chaque étape du développement.